Razonamiento de la inteligencia artificial: Limitaciones y Perspectivas Actuales

Descubre las limitaciones del razonamiento de la inteligencia artificial y experimentos recientes, como los de Apple, que podrían cambiar nuestra perspectiva.

Descubre las limitaciones del razonamiento de la inteligencia artificial y experimentos recientes, como los de Apple, que podrían cambiar nuestra perspectiva.

puntos clave

En un mundo donde los avances en inteligencia artificial (IA) son cada vez más frecuentes, una pregunta se alza entre la comunidad tecnológica e incluso la sociedad en general: ¿Realmente la IA razona o simplemente aparenta hacerlo?

Tras desplegar una mirada al contexto actual, queda evidente que el auge de los modelos de IA ha generado un interés sin precedentes en decodificar este enigma. En este artículo, abordaremos algunas de las investigaciones y experimentos más relevantes en el área, con la finalidad de echar luz sobre la interrogante central.

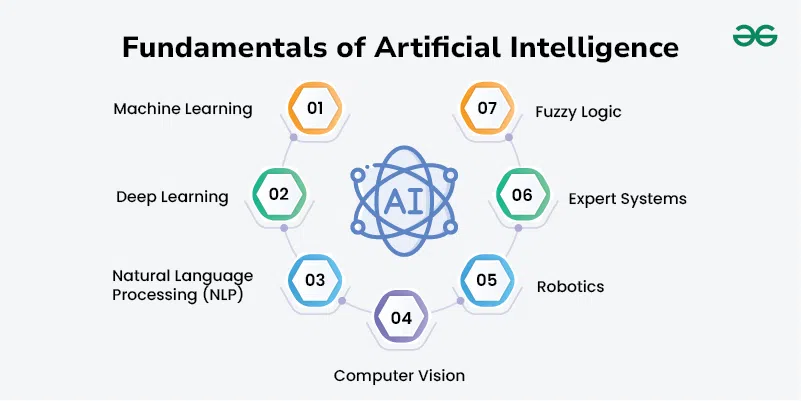

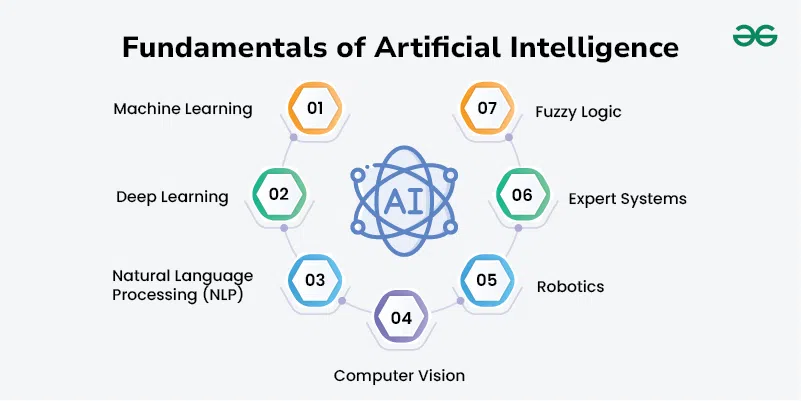

En términos sencillos, el razonamiento de la inteligencia artificial se refiere a la aptitud de un algoritmo para interpretar datos y tomar decisiones en consecuencia. Hasta hace poco, los modelos de IA tradicionales se enfocaban en ofrecer respuestas directas a preguntas concretas, tornándose sumamente eficaces en tareas específicas.

Sin embargo, los modelos de razonamiento a gran escala (LRM por sus siglas en inglés) han emergido con una propuesta distinta: nuevas metodologías que prometen un razonamiento más amplio y adaptable. Estos nuevos modelos están siendo sometidos a rigurosas pruebas, a fin de evaluar su capacidad para razonar en situaciones sin precedentes.

Una entidad que ha estado a la vanguardia en los experimentos de razonamiento en IA es Apple. Sus recientes pruebas han utilizado algunos de los rompecabezas computacionales más clásicos para evaluar la capacidad de razonamiento de la IA. Algunos paradigmas populares incluyen la Torre de Hanoi, los Saltos en Damas, el Cruce del Río y el Mundo de Bloques.

Cada uno de estos desafíos ha sido meticulosamente diseñado para evaluar el razonamiento de la IA en entornos controlados, donde cada movimiento puede ser verificado y la dificultad ajustada al nivel apropiado.

El proceso de evaluación implicó comparar distintos tipos de modelos. Entre ellos destacaron el Claude 3.7 Thinking y el DeepSeek R1, ambos con y sin razonamiento explícito. En estas pruebas, se hizo uso de largos presupuestos de tokens y se recurrió a distintas métricas, como "pass at K" y el rastreo de pasos correctos.

De esta manera, se buscaba no solo evaluar el desempeño de los modelos, sino también discernir patrones y limitaciones en su razonamiento.

Entre los hallazgos más destacados, se confirmó que en los problemas simples, los modelos sin razonamiento tienden a tener un rendimiento superior. Sin embargo, en los desafíos de complejidad media, los modelos con razonamiento explícito mostraron una mejor actuación, aunque requirieron una cantidad significativamente mayor de recursos.

Curiosamente, ninguno de los modelos probados fue eficiente en la resolución de problemas de alta complejidad, donde la precisión de la IA se desplomó de forma dramática. Este fenómeno se denomina "límite de escalado contraintuitivo", en el que, a pesar de disponer de recursos suficientes, los modelos parecen dedicar menos esfuerzo al aumentar abruptamente la dificultad.

Una de las limitaciones más evidentes en la capacidad de razonamiento de la IA es la dificultad para ejecutar largas cadenas lógicas, incluso cuando la solución se les proporciona paso a paso. Esto no se debe a una falta de memoria, sino a una incapacidad intrínseca para razonar simbólicamente durante muchas etapas.

Veamos, por ejemplo, el caso del rompecabezas de la Torre de Hanoi y el Cruce del Río. A pesar de su aparente simplicidad, estas tareas requieren un razonamiento lógico detallado que, hasta ahora, las máquinas de IA luchan por replicar eficientemente.

Hasta aquí, hemos explorado la esencia del razonamiento en la inteligencia artificial, los experimentos pioneros realizados por Apple y hemos propuesto una mirada minuciosa a las limitaciones más significativas en el razonamiento de la IA.

Un reciente artículo académico del psicólogo cognitivo y crítico de la IA, Gary Marcus, apunta que los modelos como los probados por Apple solo pueden reproducir y recombinar patrones previamente aprendidos, pero carecen de la habilidad para crear nuevos conceptos o realizar razonamiento simbólico. Por tanto, argumentó, la inteligencia artificial actual no razona realmente como los humanos ni sigue los algoritmos clásicos.

En el otro extremo, Analista Brian y el Programador Godki sostienen que las limitaciones observadas podrían ser simplemente un reflejo del diseño de los modelos, de decisiones tomadas para ahorrar recursos o de falta de entrenamiento adecuado. También cuestionaron si los rompecabezas simbólicos son realmente una medida válida del razonamiento de la inteligencia artificial, sugiriendo la posibilidad de un sesgo intrínseco en este tipo de pruebas.

Dejando a un lado los rompecabezas, se realizó una evaluación de los modelos de inteligencia artificial con preguntas de matemáticas de preparatoria y universidad. Los resultados presentaban un patrón similar: los modelos rendían notablemente bien cuando se les presentaban problemas para los que tenían datos de entrenamiento previos y, de manera contrastante, su desempeño caía cuando se enfrentaban a pruebas completamente nuevas.

Esta tendencia a obtener mejores resultados en conjuntos de datos conocidos y peores en tareas inéditas refleja cómo queda mucho por aprender sobre los límites y potencialidades de la inteligencia artificial.

Hay quienes sugieren que el razonamiento observado en los modelos de inteligencia artificial es meramente un repaso de patrones aprendidos más que un pensamiento genuino. Sin embargo, no puede descartarse la posibilidad de que nuevas mejoras en la estructura y tokens de los algoritmos puedan permitir avances significativos en su capacidad de razonamiento.

Mientras algunas voces sugieren que bastaría mejorar los modelos actuales, otras enfatizan la necesidad de confrontar un paradigma completamente nuevo. Evidentemente, existe un margen considerable de debate y desacuerdo en este terreno en constante evolución.

En conclusión, los experimentos recientes han arrojado luz sobre las restricciones profundas y la paradoja de la inteligencia artificial tal como la conocemos en la actualidad. A pesar de los avances significativos, la capacidad de los modelos de IA para razonar de la misma manera que los humanos permanece siendo, en gran parte, un problema sin resolver.

Nuestra comprensión de la inteligencia artificial y su capacidad de razonamiento influye tanto en las aplicaciones prácticas como en las expectativas sociales y filosóficas de lo que el futuro puede depararnos. Es por eso que es crucial continuar profundizando en esta vertiginosa línea de investigación.

Invitamos a nuestros lectores a reflexionar, comentar y participar en el debate. ¿Crees que la inteligencia artificial puede llegar a razonar como los humanos? ¿Cuál es tu postura? Estamos ansiosos por escuchar tus puntos de vista.