Seguridad en inteligencia artificial: Riesgos y estrategias para mitigar amenazas

Descubre cómo la seguridad en inteligencia artificial es crucial para prevenir riesgos y mitigar amenazas en el uso de IA y ciberseguridad.

Descubre cómo la seguridad en inteligencia artificial es crucial para prevenir riesgos y mitigar amenazas en el uso de IA y ciberseguridad.

La inteligencia artificial (IA) es fundamental en la vida cotidiana y empresarial, destacando la importancia de la seguridad en inteligencia artificial para asegurar resultados fiables y éticos. Los riesgos de la IA incluyen errores de diseño, manipulación de datos, y dependencia excesiva. La IA impacta en la seguridad y ciberseguridad, fortaleciendo defensas pero también abriendo puertas a ataques sofisticados. Abordan problemas éticos como el sesgo algorítmico y la protección de datos. Se proponen medidas para la prevención de riesgos y estrategias de gestión, destacando la necesidad de auditorías periódicas , gobernanza y marcos regulatorios.

En plena era digital, la inteligencia artificial (IA) se ha erigido como un pilar fundamental en la vida cotidiana y empresarial, posicionándose desde asistentes virtuales hasta sistemas avanzados de diagnóstico médico y automatización empresarial con IA. Con ese creciente protagonismo, surge un concepto esencial para garantizar la confiabilidad de estos sistemas: la seguridad en inteligencia artificial.

La seguridad en inteligencia artificial engloba la protección de los sistemas de IA, así como la garantía de que los resultados que se obtienen son fiables y éticos. No se trata simplemente de prevenir ataques o vulnerabilidades técnicas, sino de asumir un espectro más amplio de riesgos y amenazas que pueden afectar a la IA, que van desde errores de diseño hasta uso indebido (Fuente: WOMCY).

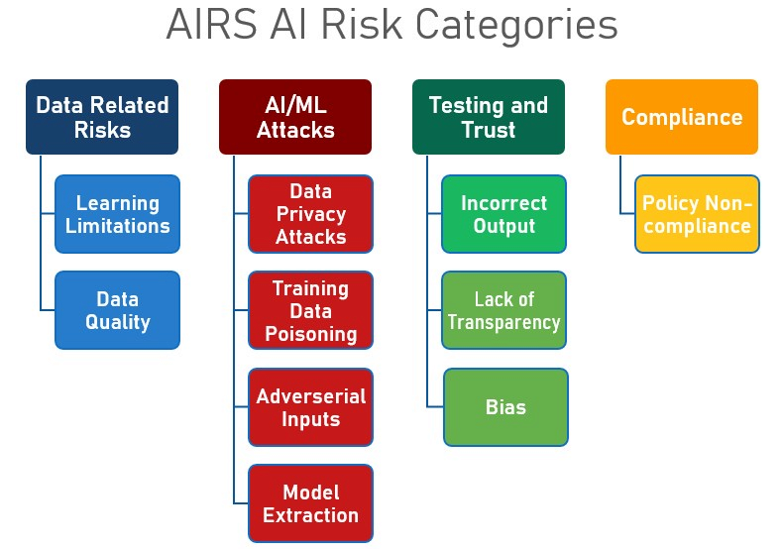

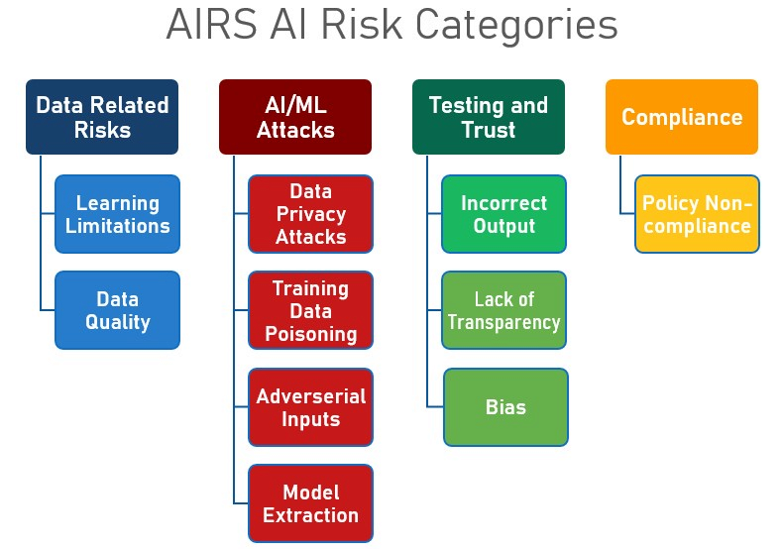

Dentro de los principales riesgos de la inteligencia artificial, merece la pena mencionar:

Asimismo, las amenazas específicas en inteligencia artificial son igualmente variadas y sofisticadas:

Además, entre las vulnerabilidades inherentes de los sistemas de IA se encuentra la dependencia de grandes volúmenes de datos, lo que los hace susceptibles a sesgos, corrupción y ataques dirigidos a la cadena de suministro de datos.

El avance de la inteligencia artificial ha repercutido de manera significativa en el ámbito de la seguridad y de la ciberseguridad. Por un lado, la IA fortalece las defensas, permitiendo la detección temprana de amenazas y la automatización de respuestas en caso de incidentes de seguridad. Sin embargo, también abre la puerta a ciberataques más sofisticados y a gran escala, como el phishing automatizado y la generación de malware.

Contamos con múltiples ejemplos de cómo la IA puede fortalecer nuestras defensas, como los sistemas que detectan fraudes bancarios en tiempo real, pero también cómo, en manos equivocadas, puede ser usada para realizar ataques personalizados y difíciles de detectar. En particular, inquieta el impacto de la IA en infraestructuras críticas y en la protección de datos, ámbitos en los que la IA puede suponer tanto una fortaleza como un riesgo si no se adoptan los controles adecuados.

Los retos que presenta la inteligencia artificial no son únicamente técnicos sino también éticos. Aquí algunos ejemplos de los problemas éticos más relevantes:

A esto, se suma la importancia de la protección de datos en IA, especialmente al manejar información personal. Es vital garantizar la anonimización de los datos y el cumplimiento de las regulaciones pertinentes, como el Reglamento General de Protección de Datos (GDPR).

Un caso real de problema ético es el de los deepfakes, que son utilizados para suplantar identidades en fraudes financieros. Asimismo, han surgido controversias con sistemas de contratación automatizada que discriminan por género debido al sesgo en los datos de entrenamiento.

La prevención y gestión de riesgos en IA se basan en la aplicación de una serie de principios y buenas prácticas. Entre las más destacadas, se encuentran:

A su vez, existen ejemplos concretos de sistemas seguros de inteligencia artificial que se han desarrollado siguiendo estos principios:

Además, para gestionar los riesgos en IA, existen diversas metodologías que pueden ser de ayuda:

Existen varias acciones clave que los desarrolladores, empresas y usuarios finales pueden tomar para mejorar la seguridad en inteligencia artificial:

En cuanto a los recursos y estándares que se recomiendan seguir, destacan los siguientes:

También es importante estar al tanto de los marcos regulatorios y certificaciones relevantes:

La seguridad en inteligencia artificial es un aspecto que debe priorizarse en la era digital. Una correcta prevención y gestión de los riesgos y una adecuada protección de los datos son vitales para garantizar la confiabilidad de los sistemas de IA. Todos, desde desarrolladores hasta usuarios finales, deben tomar parte en la construcción de una IA segura y ética.

A nivel estratégico, contar con una visión clara de los desafíos y amenazas, y adoptar medidas preventivas y éticas, es fundamental para enfrentar los retos que conlleva la seguridad en inteligencia artificial. A medida que la tecnología avanza, también lo hacen las amenazas. Por lo tanto, la colaboración, innovación y automatización empresarial con IA serán determinantes en la capacidad para manejar la seguridad en la IA de manera efectiva.

La seguridad en inteligencia artificial es la disciplina que se encarga de proteger los sistemas de IA frente a posibles amenazas, vulnerabilidades y usos indebidos, así como de garantizar la confiabilidad y la ética de los resultados que se obtienen.

Los riesgos de la inteligencia artificial incluyen errores y fallos de diseño, manipulación y uso indebido de datos y dependencia excesiva de los sistemas de IA. Las amenazas específicas pueden ser ataques adversariales, manipulación de datos, suplantaciones o deepfakes.

La IA puede potenciar las herramientas de defensa, como la detección temprana de amenazas y la automatización de respuestas, pero también abre la puerta a ataques más sofisticados y a gran escala.

Los retos éticos en IA incluyen sesgo algorítmico, decisiones automatizadas y la asignación de responsabilidad. En cuanto a la protección de datos, es fundamental garantizar la privacidad, el cumplimiento normativo y el uso responsable de la información.

Se recomienda aplicar principios de diseño seguro, realizar pruebas adversariales e implementar auditorías periódicas. Además, es muy beneficiosa la evaluación continua de amenazas, la existencia de planes de contingencia y la instauración de gobernanza tecnológica.

Algunas recomendaciones son: realizar auditorías y monitoreos continuos, limitar la información personal utilizada y compartida, y capacitar a los equipos en riesgos y mejores prácticas. También es recomendable adoptar marcos de gestión de riesgos y cumplir con regulaciones y certificaciones relevantes.